Hoy en día, es difícil imaginar una tecnología tan apasionante y aterradora como el aprendizaje automático. Mientras que la cobertura mediática y los artículos de investigación promocionan constantemente el potencial del aprendizaje automático para convertirse en el principal impulsor del cambio positivo en los negocios y la sociedad, la pregunta persistente en la mente de todos es: “¿Y si todo sale mal?”.

Durante años, los expertos han advertido contra los efectos imprevistos de la inteligencia artificial general (AI) en la sociedad. Ray Kurzweil predice que en 2029 las máquinas inteligentes podrán ser más astutas que los seres humanos. Stephen Hawking argumenta que ” una vez que los humanos desarrollen IA completa, despegará por sí misma y se rediseñará a un ritmo cada vez mayor “. Elon Musk advierte que AI puede constituir un ” riesgo fundamental para la existencia de la civilización humana “. Las opiniones alarmistas sobre el aterrador potencial de la IA general abundan en los medios.

La mayoría de las veces, estas profecías distópicas se han encontrado con llamadas para una implementación más ética de los sistemas de inteligencia artificial; que de alguna manera los ingenieros deberían imbuir a los sistemas autónomos con un sentido de ética . De acuerdo con algunos expertos en inteligencia artificial , podemos enseñar a nuestros futuros jefes supremos de robots a diferenciar el bien del mal, como una ” buena inteligencia samaritana ” que siempre actuará con justicia y ayudará a los humanos en peligro.

Aunque este futuro todavía está a décadas de distancia, hoy hay mucha incertidumbre sobre cómo, si es que lo hacemos, alcanzaremos este nivel de inteligencia general de la máquina. Pero lo más importante, en este momento, es que incluso las estrechas aplicaciones de inteligencia artificial que existen en la actualidad requieren nuestra atención urgente en la forma en que están tomando decisiones morales en situaciones prácticas cotidianas. Por ejemplo, esto es relevante cuando los algoritmos toman decisiones sobre quién tiene acceso a los préstamos o cuándo los automóviles que conducen tienen que calcular el valor de una vida humana en situaciones peligrosas.

Enseñar moralidad a las máquinas es difícil porque los humanos no pueden transmitir objetivamente la moralidad en métricas mensurables que faciliten el proceso de una computadora. De hecho, es incluso cuestionable si nosotros, como humanos, tenemos una comprensión sólida de la moralidad en la que todos podemos estar de acuerdo. En los dilemas morales , los humanos tienden a confiar en la sensación visceral en lugar de cálculos elaborados de costo-beneficio. Las máquinas, por otro lado, necesitan métricas explícitas y objetivas que puedan ser claramente medidas y optimizadas. Por ejemplo, un jugador de IA puede sobresalir en juegos con reglas y límites claros al aprender a optimizar el puntaje a través de repetidas jugadas.

Después de sus experimentos con aprendizaje de refuerzo profundo en los videojuegos Atari , DeepMind de Alphabet fue capaz de vencer a los mejores jugadores humanos de Go . Mientras tanto, OpenAI acumuló “vidas” de experiencias para vencer a los mejores jugadores humanos en el torneo Valve Dota 2, una de las competiciones de deportes electrónicos más populares a nivel mundial.

Pero en situaciones de la vida real, los problemas de optimización son mucho más complejos. Por ejemplo, ¿cómo se enseña una máquina para maximizar matemáticamente la equidad o para superar los sesgos raciales y de género en sus datos de entrenamiento? A una máquina no se le puede enseñar lo que es justo a menos que los ingenieros que diseñan el sistema de IA tengan una concepción precisa de lo que es la equidad.

Esto ha llevado a algunos autores a preocuparse de que una aplicación ingenua de algoritmos a los problemas cotidianos podría amplificar la discriminación estructural y reproducir los sesgos en los datos en los que se basan. En el peor de los casos , los algoritmos podrían negar servicios a las minorías, impedir las oportunidades de empleo de las personas o elegir al candidato político equivocado.

Según nuestras experiencias en el aprendizaje automático, creemos que hay tres formas de comenzar a diseñar máquinas más alineadas éticamente:

1. Definir el comportamiento ético

Los investigadores y especialistas en ética de la IA necesitan formular valores éticos como parámetros cuantificables. En otras palabras, necesitan proporcionar máquinas con respuestas explícitas y reglas de decisión a cualquier posible dilema ético que pueda enfrentar. Esto requeriría que los humanos acuerden entre ellos el curso de acción más ético en cualquier situación dada, una tarea desafiante pero no imposible. Por ejemplo, la Comisión de Ética de Alemania sobre Conducción Automatizada y Conectada ha recomendado programar específicamente valores éticos en automóviles sin conductor para priorizar la protección de la vida humana por encima de todo lo demás. En caso de un accidente inevitable, el automóvil debería estar “prohibido para compensar a las víctimas entre sí”. En otras palabras, un automóvil no debería poder elegir si matar a una persona en función de características individuales, como la edad, el sexo o la constitución física / mental cuando un accidente es inevitable.

2. Crowdsource nuestra moralidad

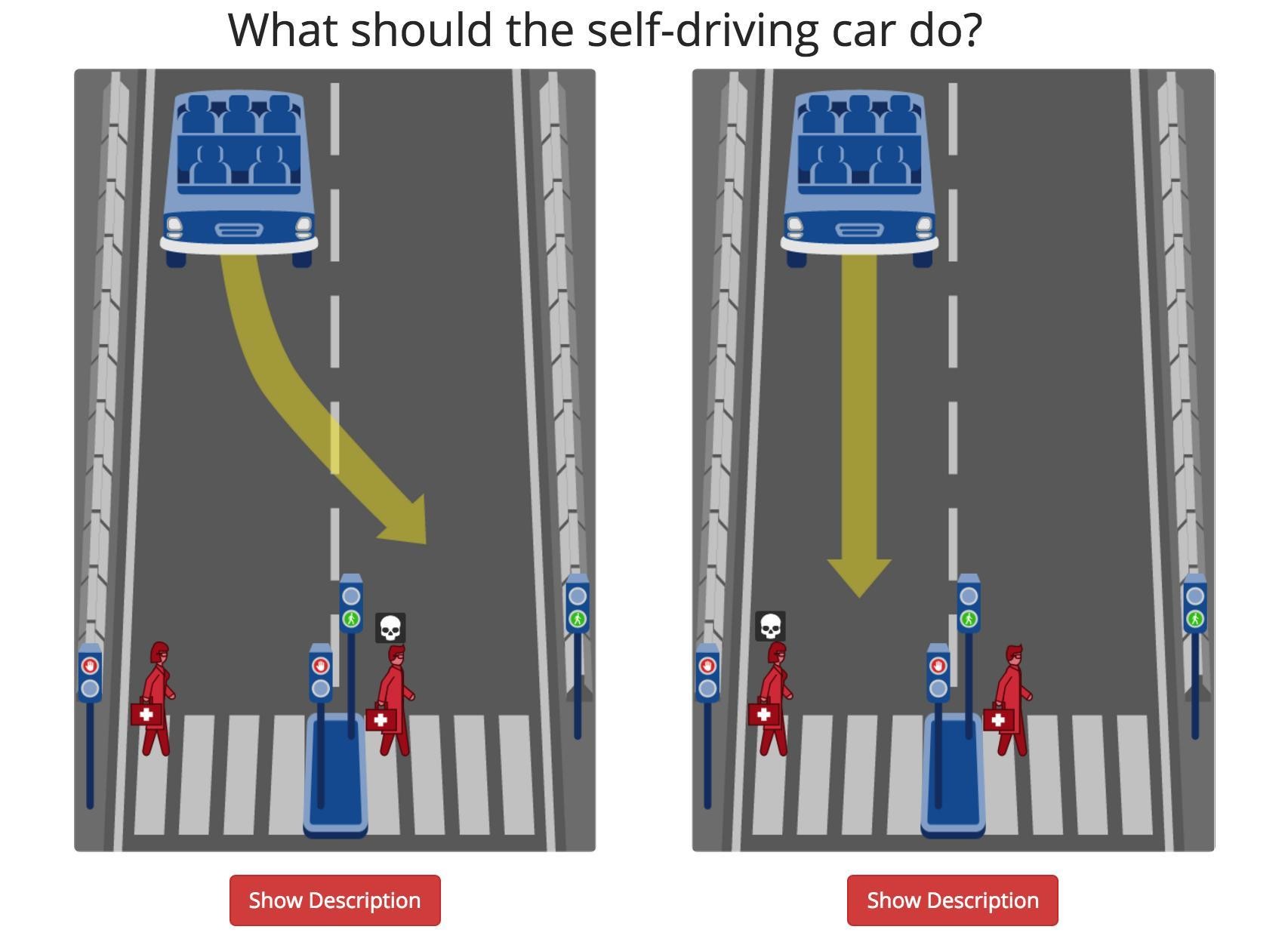

Los ingenieros necesitan recopilar suficientes datos sobre medidas éticas explícitas para entrenar adecuadamente los algoritmos de inteligencia artificial. Incluso después de que hayamos definido métricas específicas para nuestros valores éticos, un sistema de inteligencia artificial aún podría tener problemas para retomarlo si no hay suficientes datos imparciales para capacitar a los modelos. Obtener datos apropiados es un desafío, porque las normas éticas no siempre se pueden estandarizar claramente . Las diferentes situaciones requieren diferentes enfoques éticos, y en algunas situaciones puede no haber un solo curso de acción ética, solo piense en las armas letales autónomas que se están desarrollando actualmente para aplicaciones militares. Una forma de resolver esto sería recurrir a soluciones potenciales potenciales a los dilemas morales de millones de humanos. Por ejemplo, el proyecto Moral Machine del MIT muestra cómo los datos de crowdsourcing se pueden utilizar para entrenar a las máquinas de manera efectiva para tomar mejores decisiones morales en el contexto de los autos sin conductor.

3. Haz que AI sea transparente

Los responsables de la formulación de políticas deben implementar directrices que hagan que las decisiones de la IA con respecto a la ética sean más transparentes, especialmente con respecto a las métricas y los resultados éticos. Si los sistemas de IA cometen errores o tienen consecuencias no deseadas, no podemos aceptar ” el algoritmo lo hizo ” como una excusa adecuada. Pero también sabemos que exigir una transparencia algorítmica completa es técnicamente insostenible (y, francamente, no muy útil). Las redes neuronales son simplemente demasiado complejas para ser inspeccionadas por inspectores humanos. En cambio, debería haber más transparencia sobre cómo los ingenieros cuantificaron los valores éticos antes de programarlos, así como los resultados que la inteligencia artificial ha producido como resultado de estas elecciones. Para automóviles que conducen por sí mismos, por ejemplo, esto podría implicar que se mantengan registros detallados de todas las decisiones automáticas en todo momento para garantizar su responsabilidad ética.

Creemos que estas tres recomendaciones deben ser vistas como un punto de partida para desarrollar sistemas de IA éticamente alineados. Al no imbuir la ética en los sistemas de inteligencia artificial, podemos ponernos en la peligrosa situación de permitir que los algoritmos decidan qué es lo mejor para nosotros. Por ejemplo, en una situación de accidente inevitable, los autos sin conductor necesitarán tomar una decisión para bien o para mal. Pero si los diseñadores del automóvil no especifican un conjunto de valores éticos que podrían actuar como guías de decisión, el sistema de IA puede llegar a una solución que cause más daño. Esto significa que no podemos simplemente negarnos a cuantificar nuestros valores. Al alejarnos de esta crítica discusión ética, estamos haciendo una elección moral implícita. Y a medida que la inteligencia artificial se generaliza cada vez más en la sociedad, el precio de la inacción podría ser enorme: podría afectar negativamente la vida de miles de millones de personas.

No se puede asumir que las máquinas son inherentemente capaces de comportarse moralmente. Los humanos deben enseñarles qué es la moralidad, cómo puede medirse y optimizarse. Para los ingenieros de IA, esto puede parecer una tarea desalentadora. Después de todo, definir los valores morales es un desafío con el que la humanidad ha luchado a lo largo de su historia. Sin embargo, el estado de la investigación en IA requiere que finalmente definamos la moralidad y la cuantifiquemos en términos explícitos. Los ingenieros no pueden construir una “buena IA samaritana”, mientras carezcan de una fórmula para el buen samaritano humano